¿Le atinaste a la traducción exacta?: Evaluando la Traducción Automática con BLEU

En la Traducción Automática se han desarrollado métricas de evaluación, basadas en la comparación de la salida del sistema (output) con una traducción de referencia estándar.

¿Le atinaste a la traducción exacta?: Evaluando la Traducción Automática con BLEU

En el campo de la traducción automática se han desarrollado diferentes métricas de evaluación, todas ellas se basan en la comparación de la salida del sistema (output) con una traducción de referencia estándar almacenada. Pero tan solo realizar dicha comparación es un gran reto, primero, porque incluso dos traductores expertos pueden realizar diferentes traducciones de una misma oración, y hacer coincidir ambas en una sola traducción de referencia humana resulta un arduo trabajo; y segundo, además de la coincidencia de palabras, también se debe evaluar el orden de estas. Por lo tanto, métodos simples, como contar el número de palabras correctas, no es suficiente, ya que ignora el orden de la oración. En ese sentido, IBM desarrolló la métrica BLEU, del inglés bilingual evaluation understudy, que es una conciliación entre ignorar y requerir un orden de palabras coincidente [1].

BLEU

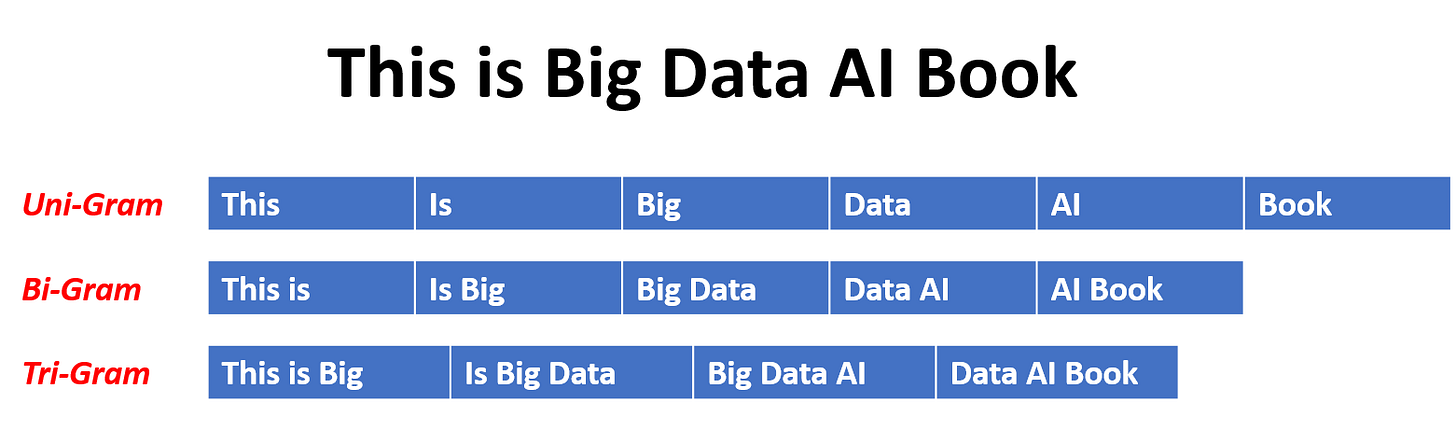

En esencia, BLEU busca no sólo que el número de palabras de la traducción coincida con la referencia, sino también que encajen con los n-gramas de orden superior [1]. Se entiende por n-grama a una secuencia contigua de n elementos de un texto, pueden ser fonemas, sílabas, letras o palabras. Como se ve en la figura:

BLEU valora el orden correcto de las palabras ya que aumenta la probabilidad de tener pares de palabras coincidentes, es decir bigramas, o incluso secuencias de tres o cuatro palabras, es decir trigramas y 4-gramas [1]. La métrica BLEU es definida como:

Donde BP es el término de penalización por brevedad, pn son las precisiones modificadas y wn son los pesos correspondientes, que suelen ser uniformes en la práctica.

La métrica BLEU está en el rango de 0 a 1, generalmente, pocas traducciones obtienen una puntuación de 1, a no ser que sean idénticas a una traducción de referencia. Por esta razón, incluso un traductor humano no necesariamente obtendrá un puntaje de 1. Además, cuantas más traducciones de referencia por oración exista, mayor será el puntaje obtenido; es por ello, que hacer comparaciones incluso "aproximadas" en evaluaciones con diferentes números de traducciones de referencia, puede resultar sesgado [3].

Finalmente, si bien la métrica BLEU es usada ampliamente en Traducción Automática (MT, por sus siglas en inglés), varios trabajos han señalado sus deficiencias. En particular, Callison-Burch et al. (2006) mostró que BLEU puede no correlacionarse en algunos casos con juicios humanos, ya que una gran cantidad de traducciones potenciales tienen la misma puntuación BLEU, y esa correlación disminuye cuando la calidad de la traducción es baja. También, algunas de las deficiencias son relevantes para la traducción monolingüe, por ejemplo, la imposibilidad de capturar sinónimos y paráfrasis que no están en el conjunto de referencias, o la ponderación uniforme de las palabras [4].

Referencias

[1] P. Koehn, Neural machine translation. Cambridge: Cambridge University Press, 2020.

[2] Padmanabhan, A., 2021. N-Gram Model. [online] Devopedia. Available at: <https://devopedia.org/n-gram-model#Mehmood-2019> [Accessed 10 December 2021].

[3] Khandelwal, R., 2021. BLEU — Bilingual Evaluation Understudy. [online] Medium. Available at: <https://towardsdatascience.com/bleu-bilingual-evaluation-understudy-2b4eab9bcfd1>

Crítica [Accessed 10 December 2021].

[4] Mathur, N., Baldwin, T. and Cohn, T., 2020. Tangled up in BLEU: Reevaluating the Evaluation of Automatic Machine Translation Evaluation Metrics. arXiv, [online] Available at: <https://arxiv.org/pdf/2006.06264.pdf> [Accessed 10 December 2021].